自分と同じ意見や考え方を持つグループの中で起きているニュースや情報にしか触れなくなってしまうというフィルターバブル。技術的な解消が徐々に進んでいく状態ではあるが、現在の問題点と自衛手段を知っておきましょう。

フィルターバブルについて

2011年にフィルターバブルという言葉を作り紹介したEli Pariserが、FacebookやGoogleで使われているアルゴリズムを例に危険性を示したTEDのビデオがあります。10分程度の短い動画で日本語の字幕もあるので、大枠はここでつかめると思います。

ここで紹介されている例として、Googleでエジプトと検索した時にひとりはデモに関することが最初に表示され、もうひとりは旅行についてのみでデモについてはまったく検索結果に表示されませんでした。このようにソーシャルメディア、サーチエンジン、ニュースアプリといった情報共有のツールは、パーソナライズという仕組みによって、利用者が興味を持つであろう情報を表示します。結果として、ユーザーはより早く求める情報にたどり着けることになります。

一方の問題として、このような仕組みをユーザーが意識できないところで、情報のバブル(カタマリ)が削除されているということを問題視しています。エジプトの例では、エジプトでの騒乱が問題になっている時に、その情報に触れることができない、気づかないという人が現れます。そして、この情報の削除が倫理観を持って行われているわけではないということが、さらに個人の生活環境に影響を与えてしまうことを問題視して、個人が透明性のもとに自分で判断できる環境が必要だと言及しています。

2016年のアメリカ大統領選挙においては、フェイクニュースという嘘の候補者への中傷がまるで本当のニュースのようにフェースブック上で共有されるという問題とともに、共和党の人は共和党の信じる情報のみを読んでおり、民主党の人は民主党の信じる情報に囲まれていた結果、まさかのトランプ大統領が生まれるという結果になりました。

フィルターバブルは問題なの?

イギリスのEU離脱に、離脱反対派が優位という報道がされた結果、反対派の投票が伸び悩み結果として離脱派の勝利という結果になりました。ここでもソーシャルメディアが一定の影響を持ったと思われますが、同時にトラディショナルなメディアの責任も問われています。

日本でも、この1週間の報道を見直すだけでも、トラディショナルメディアの意図的におこなっているフィルターバブルは簡単に見つかります。自民党の憲法改正推進本部会合を報じた新聞各社の報道の要旨が、

読売・毎日・東京:首相案に「賛成が相次いだ」

産経・日経:意見が「まっぷたつに別れたと」

朝日:「異論が噴出と」

と同じ会議を傍聴した結果とはとても思えない恣意的なフィルターがかかっている記事となっています。これがコラムや社説であれば、解説委員などの個人の意見であることがわかりますが、上記のニュースはあくまでも事実を伝えるという体のニュース。他にも、菅官房長官が記者会見でテレビ放送においての電波使用についてオークションの実施可能性を示唆したことについては、産経以外はすべての新聞・テレビも触れないというフィルターがかかっています。

海外のように自社の政治的な立場を明確にしている媒体と違い、日本においては全社が中性効率を謳っているというのが無意識のフィルターを作り出しています。

では、個人の発信している情報が信頼できるのかというと、個人はそれぞれの立ち位置があり、その信条に基づいた意見表明をしています。もしくは、アフィリエートで収益を上げるために広告主のためになる記事を書くということもあります。マスメディアの提灯記事を書く広告やタイアップの仕組みは、個人向けのインターネットメディアにもしっかり移植されています。

インターネットが無い頃は1次情報に触れる機会が少なく、フェイクニュース、マスゴミ、報じない権利などと今となっては揶揄される行動を俯瞰できる環境がありませんでした。インターネットによって多くの目が注がれ、比較されるという環境ができたことは間違いなく進歩です。それが、技術の進歩によって検索結果やタイムラインに無意識なフィルターがかかり、数十年前の状態に戻る可能性があるというのは皮肉ですね。

さらに、フェースブックについてはアルゴリズムだけではなく、トレンディングというエンジニアのチームが情報やトピックをチェックして、優先順位や表示される順番をマネージメントしているとギズモードのインタビューにフェースブックは答えています。では、このエンジニアの政治的信条が影響しないのか?というのが議論になりました。アルゴリズムが中立的に個人の役に立つようにという仕組みだったとしても、人為的なバイアスが排除されているとは限らないということになります。

フィルターバブルへの対策

パーソナライズされた情報というのは快適で便利です。私のタイムラインにタレントの離婚や不倫というニュースよりも、技術や美味しい食べ物について表示されるのは時間の使い方を効率的にしてくれます。しかし、フィルターバブルがやっかいなのは、マスメディアのように悪意を持って行われている行動ではないため、無意識なフィルターになりやすいことです。ということで、基礎的な対策がいくつか提案されています。

- 自分の興味・関心とまったく立場の違うアカウントをフォローする

- 毎日違う立場のエントリーをクリックして閲読していることをアルゴリズムに伝えて、多彩な意見に興味がある人だと認識してもらう

- 立場の違うアカウントは読むだけにして一切会話をしない。アルゴリズムがあなたと立場の違うアカウントが交わした会話から、ひとつのバブルをフィルターアウトする可能性があります。ROMしましょう。

あまり前向きに対応ではないですが、無意識を意識に変化させるためには有効な手段です。

まとめ

情報である以上バイアスから自由であることはなく、なんらかの視点から情報は書かれています。フィルターバブルと聞いて嫌悪を示す人もいれば、私のように利益をうけるためにバーターとして失われるものがあっても仕方がないと思う人もいます。加えて、多様な視点(Introspective)というのは、言うほど楽ではなく、時間を消費します。

すくなくとも、定期的に自分がどのようなフィルターバブルの上にいるのか定期的にチェックできる仕組みがあれば、健康診断のように使えるのかもしれません。

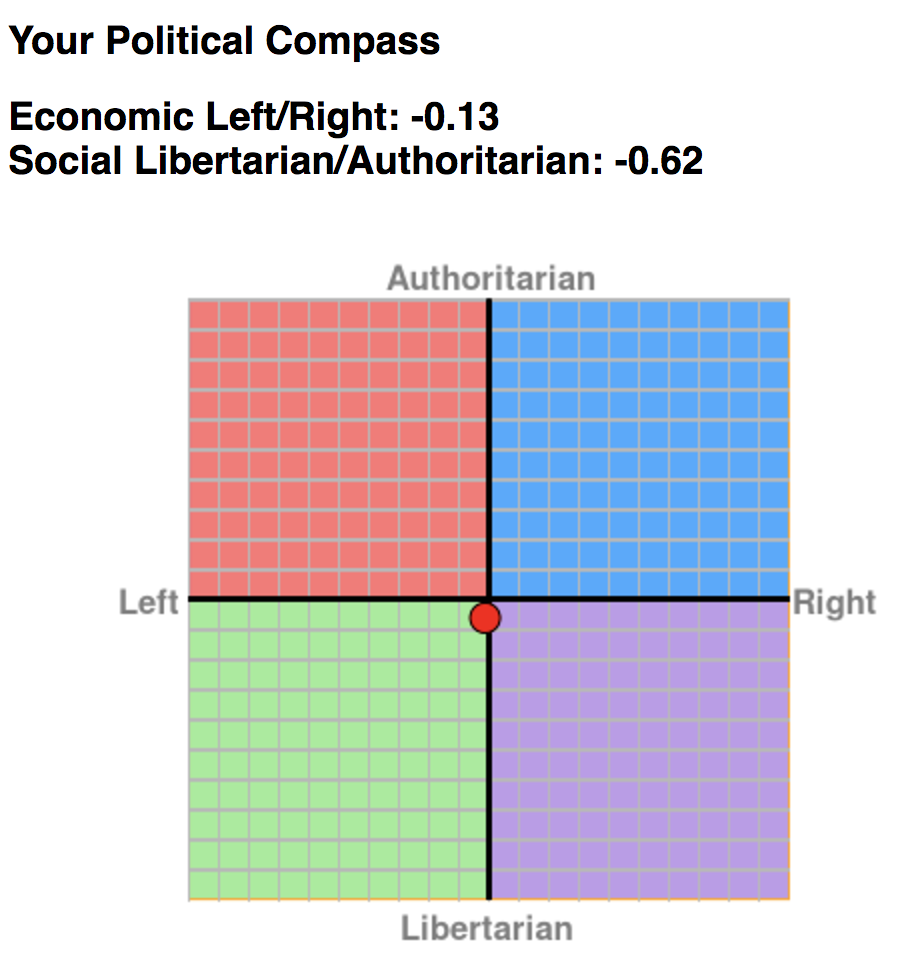

健康診断を読み解くにあたっては、自分の政治的なな立ち位置を理解しておくのも重要ですので、意識している、していないにかかわらず、オンライン上の政治信条を調べるツールなどを受けてみるのもいいかもしれません。

ちなみに僕はど真ん中です。